1 数字人表情自动生成与制作生成概要

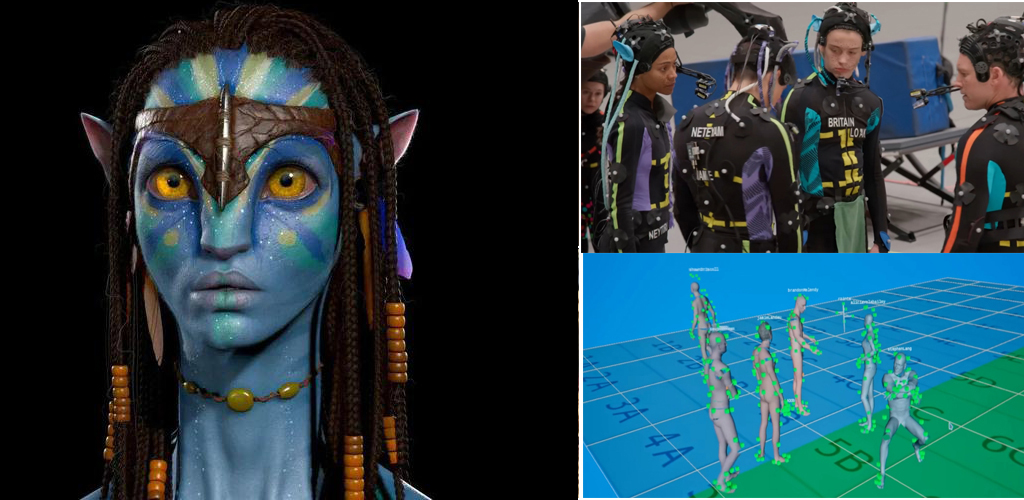

近年来, 随着以深度学习为核心的人工智能技术的飞速发展, 虚拟数字人技术受到了越来越多的关注. 虚拟数字人技术包括人物形象的设计建模、人脸的 3D 生成、人物动作表情的捕捉与生成、音视频的合成显示与交互等, 特别是聚焦人物头部的虚拟数字人表情在虚拟世界中有着广阔的应用前景。就拿电影行业来说,电影制作团队能够利用数字人技术为观众呈现出更加逼真和震撼的视觉效果。这种技术的飞速发展为电影等行业带来了无限的可能性和超强的视觉感受,许多优秀的电影作品都运用了数字人技术,使历史人物、虚构角色和神奇生物在银幕上栩栩如生。比如,詹姆斯·卡梅隆执导的科幻巨作《阿凡达:水之道》就采用了先进的数字人技术,将人类与纳美族的虚构世界相融合,并且为演员添加了CG数字角色丰富细腻的表情,为观众提供了逼真的视觉享受。《复仇者联盟》中利用数字人表情生成技术,使观众能够看到年轻版的托尼·斯塔克、史蒂夫·罗杰斯和索尔·奥丁森等角色,为电影增添了情感色彩与无限回忆。

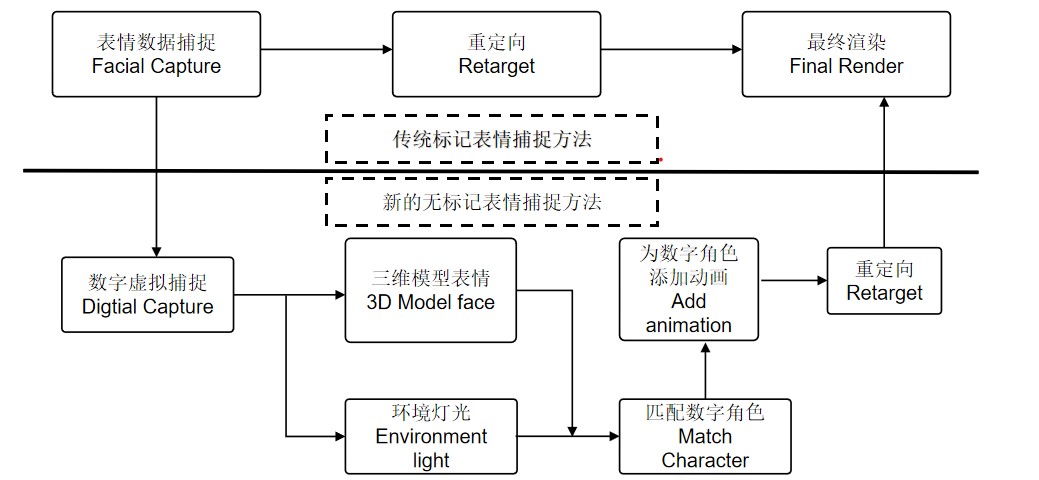

高质量虚拟数字人中, 数字人的微表情生成主要依赖于真人的头部与面部动作捕捉, 如高分辨率相机,表情捕捉系统等; 这种方法过度依赖昂贵的设备和专业的表演人员。如何利用前沿人工智能技术突破这些限制, 实现高清逼真的数字人表情生成 , 已迅速成为虚拟数字人最受关注的方向之一,也是未来数字虚拟人和人工智能技术结合的探索领域[4] 。数字虚拟人由于无实物的特征,它有区别于真实人脸的标记捕捉算法,尤其在电影中,传统的制作方法是先标记点捕捉真实人脸数据,然后直接用运动数据匹配模型,但问题也会很多,例如许多数据需要大量的修正工作,而本文介绍的这种工作流程,主要针对于数字人角色的无标记点面部捕捉方法[5],如下图所1所示。

图1 传统标记表情捕捉与新的无标记表情捕捉对比

在面部表情捕捉完成的同时,再根据数字虚拟人添加的动画(包括骨骼的绑定),和声音的录制,最终发布在数字人平台,生成数字虚拟对象。

2 基于表情生成的数字人制作技术

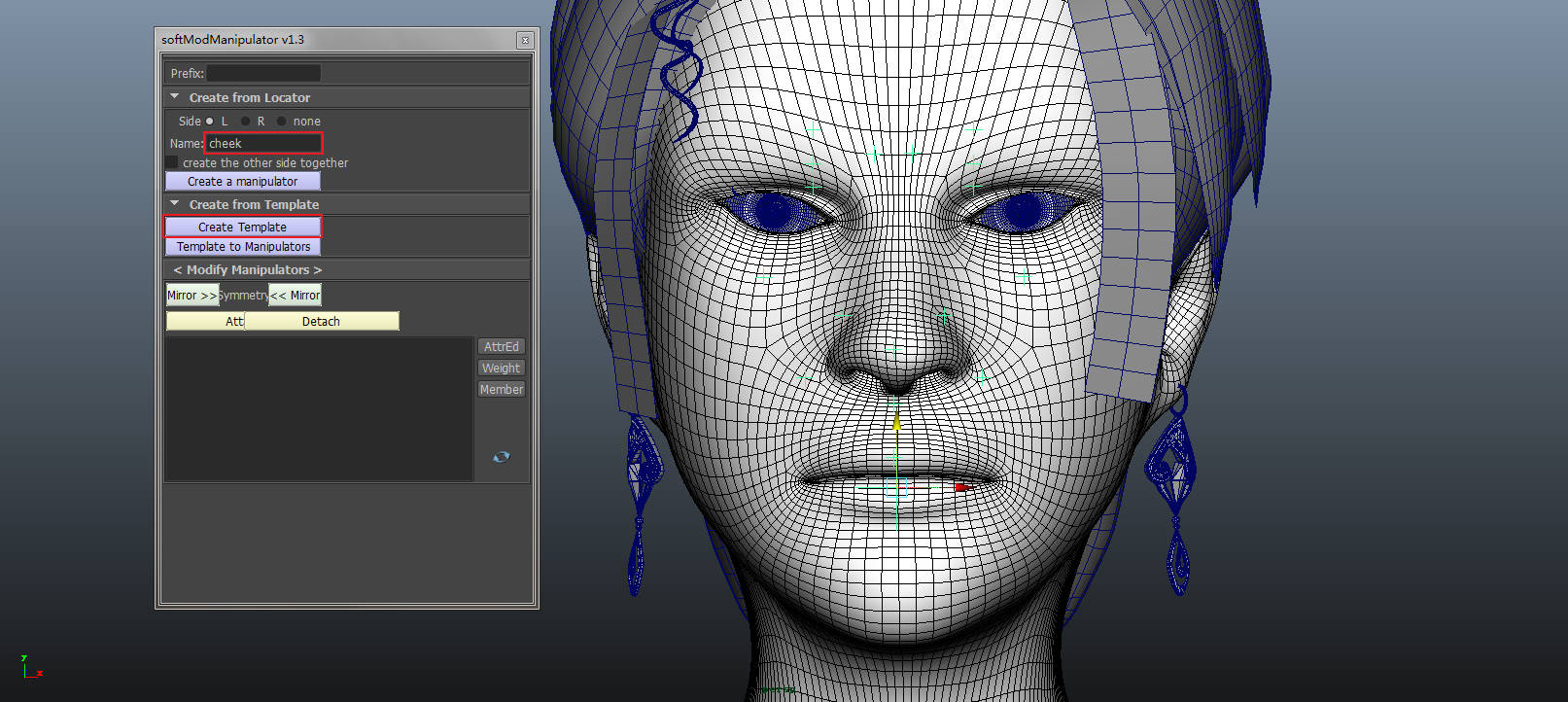

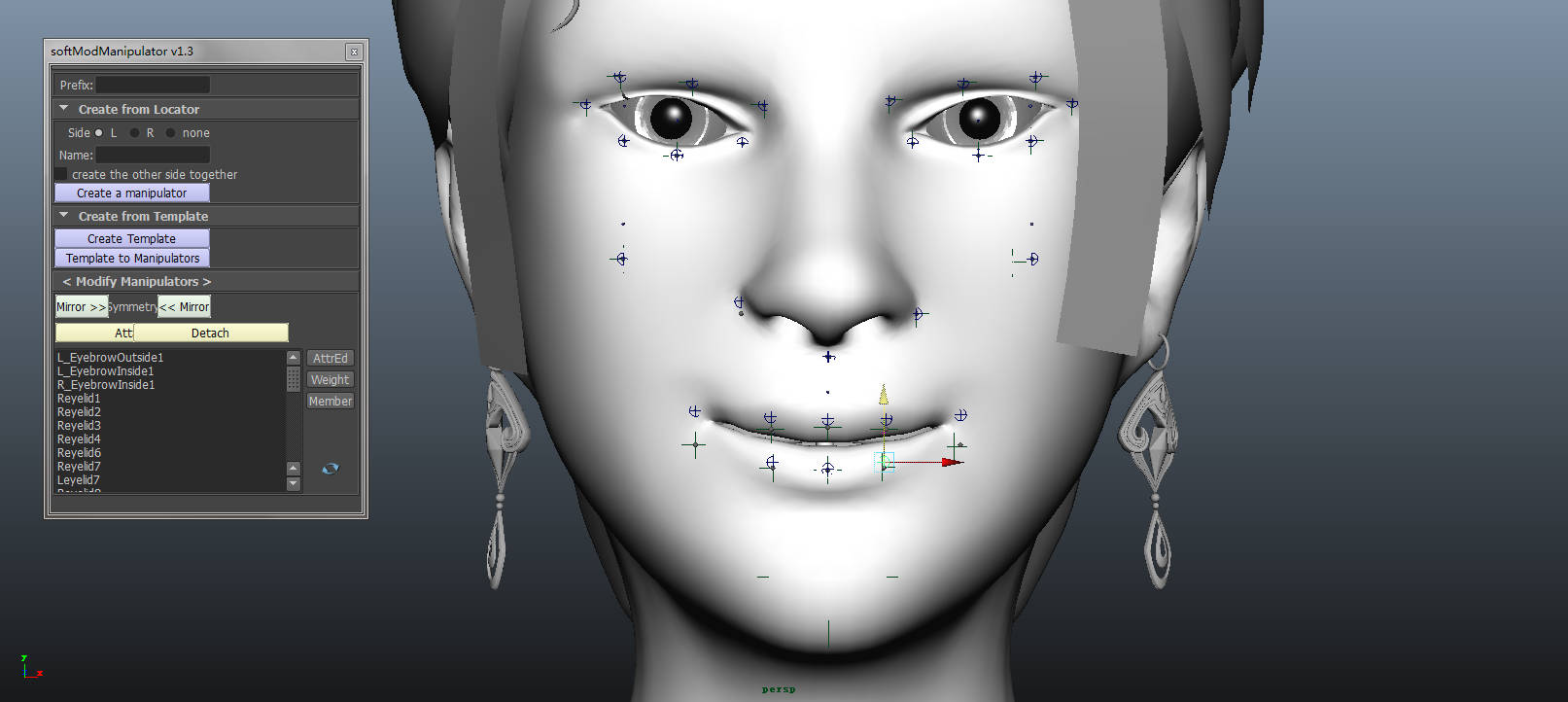

2.1基于Soft Mod Manipulator工具的面部表情生成

Soft Mod Manipulator是与Maya软件无缝整合的面部表情生成插件。通过拖拽将插件拉入Maya软件之中,可以在输入栏输入面部表情的信息和参数,生成无标记的可控制点,然后通过绑定到模型上,达到控制住模型表面变化的目的。

图2 基于Soft Mod Manipulator的窗口面板

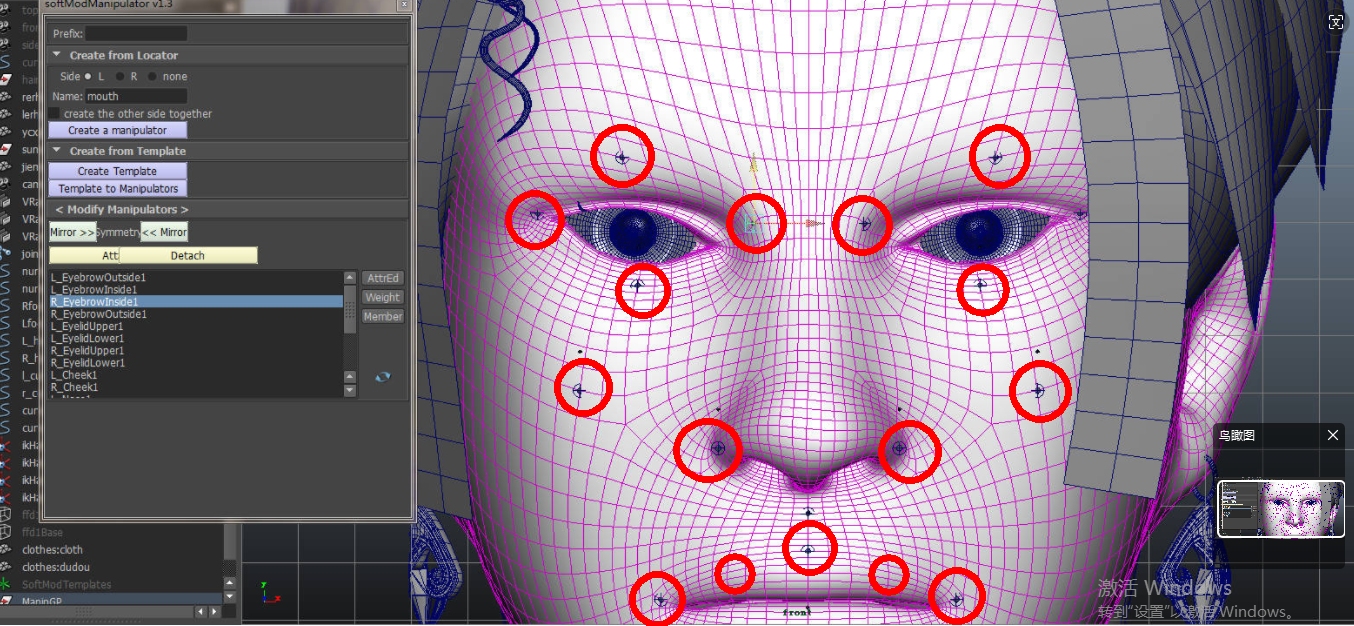

Dilb库是较为经典的人脸特征检测库,其人脸特征点检测又快又准。基于Dilb的人脸检测方法可以测出68个特征点,但实际利用OpenCV算法可以算出更多的检测点,不过,本文这里对传统的检测点进行了优化,通过抓住模型重要发生表情的部位,即明显的表情特诊点,然后运用Soft Mod Manipulator绑定他,来收集这些特征点转化为捕捉点就可以了。根据Dilb库检测的这些表情重要表情特征点包括:

(1)眼部一圈部位,取重要位置的点;比如左,右眼角;上、下眼部的左右两端;

(2)眉头和眉梢中间的点,这些点都会随着表情的变化而改变位置;

(3)两侧嘴角,以及嘴的上下两边的部位,这些点对嘴的左右运动和上下张合有明显 的影响;

(4)脸颊部位的点,会因眼部的变化而受影响。

(5)鼻翼和人中部位,会因嘴部的变化而受影响。

上述这些表情特征点的三三两两组合,可以涵盖大多数角色微表情所产生的变形,包括喜、怒、哀、乐及说话等面部表情。见图3。

图3 CG人物的主要表情特征点

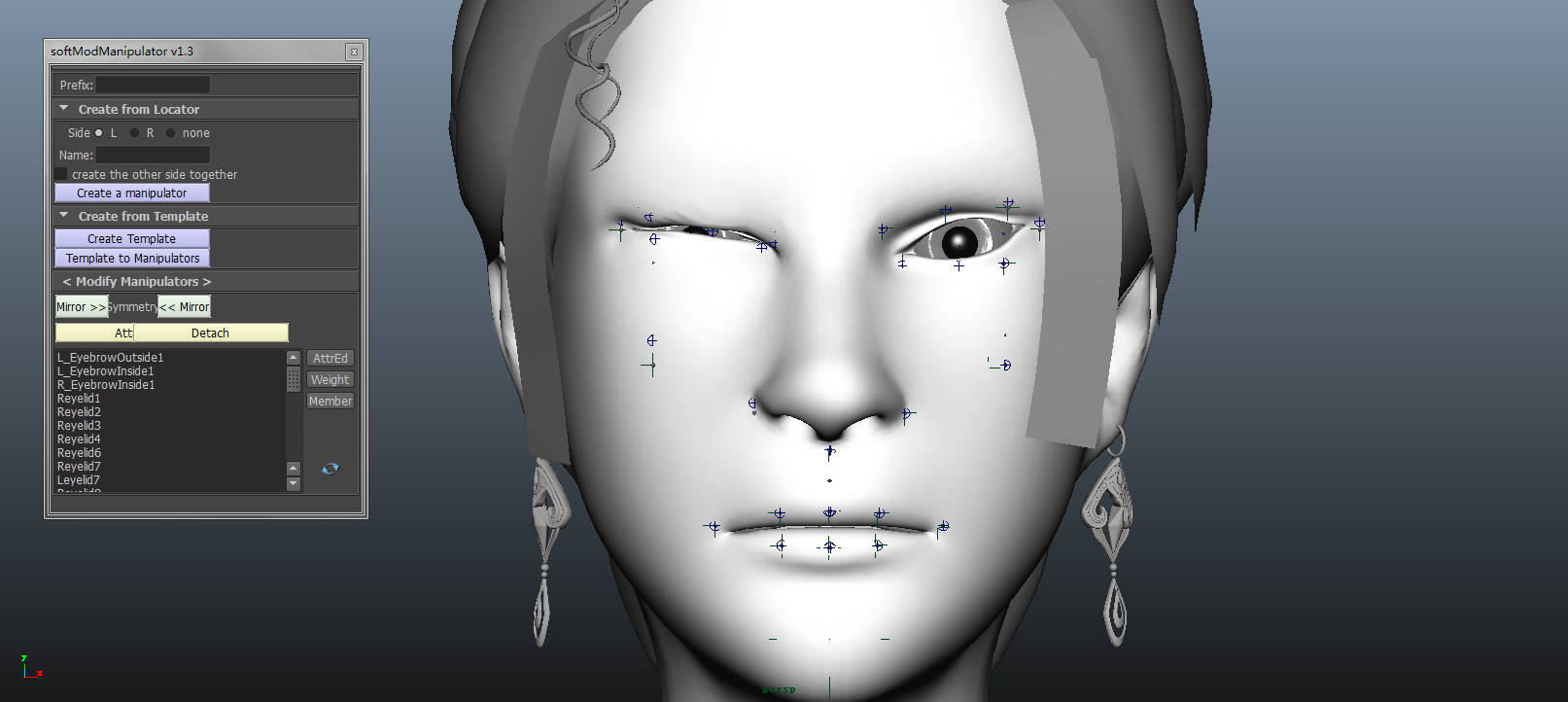

根据Dilb检测的这些点进行划分,利用Soft Mod Manipulator绑定住角色的重要特征点部位,即可生成面部的捕捉点,在面板中分别调整和控制这些点的参数,最后成功生成下图中的表情。见图4。

图4 Close eyes 与 mouth smile 表情图

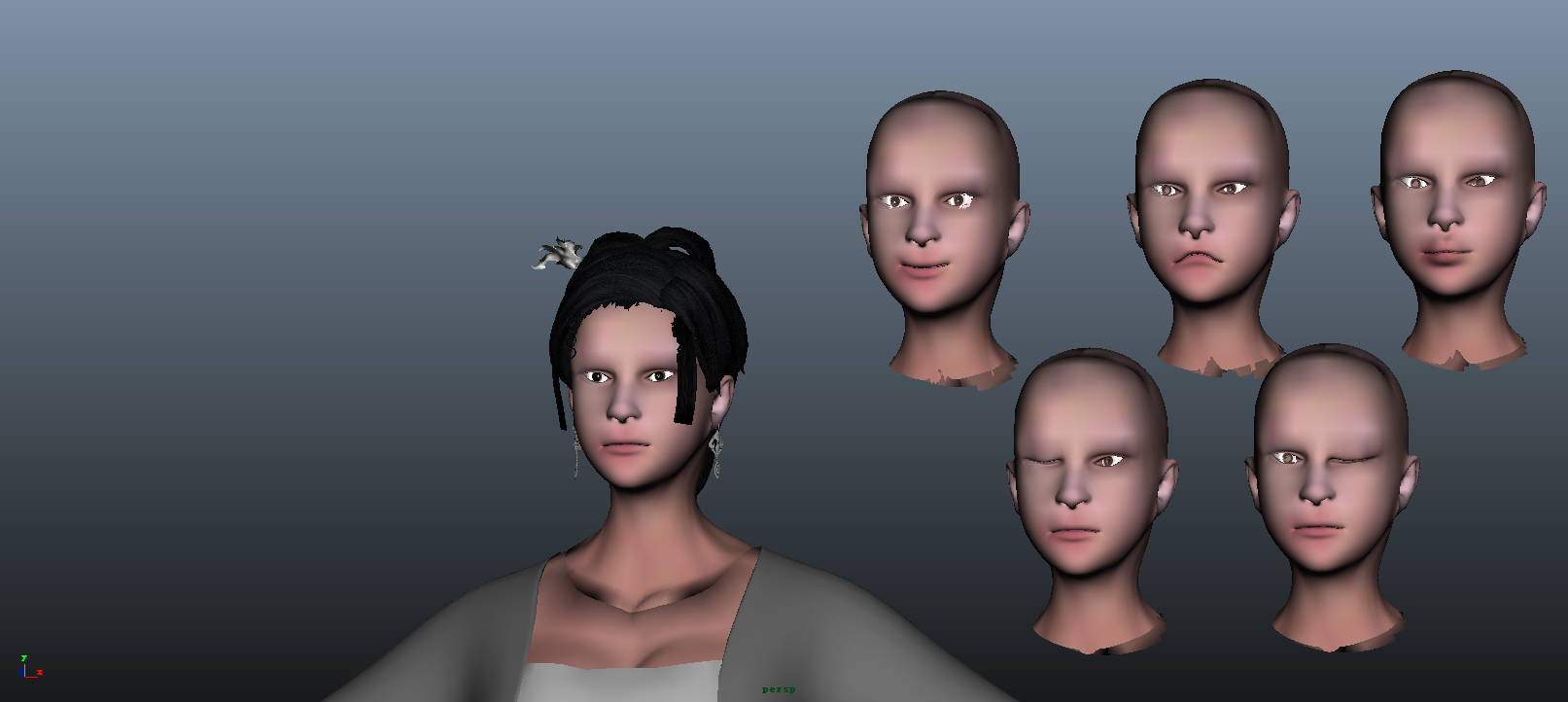

2.2 Blend shape与各种微表情的融合变形

Blend shape是一种动画融合技术,如著名的3Dsmax、Maya、Blend等软件均有该功能。在Maya里可以作为表情的专门制作技术,除了用Open CV 介绍的Blend shape动画技术之外,最直接的方法就是使用Maya中自带的Blend shape融合工具,Maya中的Blend shape变形器是将一个对象的形状改变成其他对象的形状,它也是通过记录特征点或目标点的位置变化, 从而改变面部表情网格的变化,达到使角色发生表情变化的目的。

在制作的过程中,需要注意的是必须进入角色(目标)对象的元素组件才能响应的调整位置变化。与其他软件的变形器有所不同,Blend shape有一个编辑器,使用该变形器属性可以控制每个融合变形器对目标对象的影响、也可以创建新的融合变形器,包括设置关键帧、表情动画等,同时它可以支持非人物角色的变形效果的生成。但另外值得注意的是,每一种表情,比如左眼闭上,就需要相应的运用Blend shape生成单独的一种表情,随后将具备该表情的模型单独复制出来一个新的模型。需要生成多少模型,就复制出多少模型。见图5。最终将生成出来的N种模型表情在Blend shape中进行集中的管理。另外,每一个脸部的关键点一般只有一个,除非涉及到局部大范围的变化,可涉及两到三个点。以下是对每个关键点进行了定义,列出了共7个变形部位。所有这些变形点的任意组合基本涵盖了整个表情动画。这样的简化设计对制作Blend shape模型非常有利。

图5 左;Blend shape 生成的多种表情模型 右;各部分关键点对应的Key

2.3 关键权值的计算方法

如果要让表情的微变化有一个准确的数值,可以利用Maya与Unity3D引擎中Blend shape的相似属性来完成。这里提出的方案就是首先将Maya中模型的数据导入Unity3D,接着可利用Unity 3D中Blend shape中的一个Basis(基础形状),所有的关键点Key对应的形变都是相对于这一基础形状完成的。可以用算法算出关键点的变化值,从而得出精确的特征点位移的变化。这个变化值可以这样计算;在表情变化前有一个校准过程,即获取关键点的原始坐标,这里命名为E_ori(n)。

D(n)= E(n)- E_ori(n)

这样一种权值计算方法是基于头部丝毫不动的情况下才能进行,表情生成后最终需要录制成视频,因此避免不了头部运动带来的偏差。这里介绍另一种相对坐标的方式,考虑到面部点与点距离和稳定性的问题,因此要找到一个发生各种表情都相对不变的点作为参考点E0,

初始化标准阶段,各个点的坐标为E_ori,各个点相对于E0的差值D_ori为:

D_or(n)=E_ori(n)- E0_ori(n)

在运行阶段,各个点相对于E0差值的变量为:

D(n)=E(n)-E0- D_or(n)

当然,上述的计算方法是基于脸部姿态基本不变或者变化并不明显的情况下完成出来的,如果是基于视频类(如电影中虚拟角色)帧图像的二维坐标改变,假若脸部的姿态发生大的变化,各个关键点的位置就会改变,那样的话就要重新再计算了。

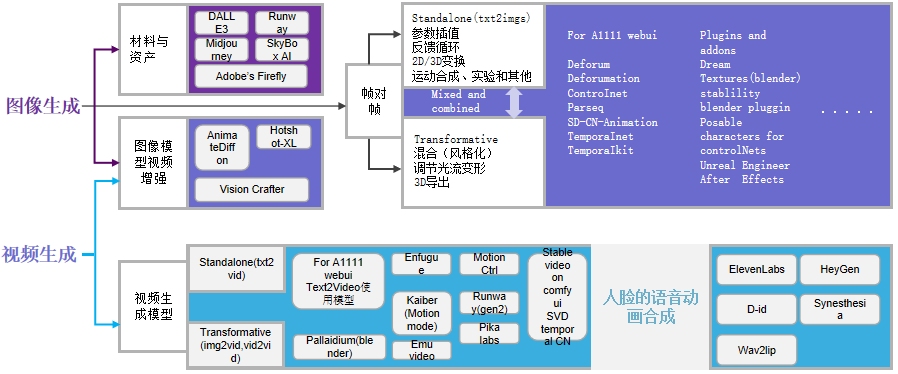

3 .AIGC赋予数字人智能生成

完成数字人微表情的生成之后,经过动画与音频的处理,就可以利用人工智能生成(AIGC)的方式赋予数字人智能化应用。随着人工智能(AI)技术在深度学习(DL)、语言处理(NLP)、计算机视觉(CV)等领域的不断突破,各种数字技术公司尤其是电影娱乐公司加大了对智能数字人的技术升级工作。

一般来说,我们可以通过传统的3D软件制作的角色三维模型来进行数字人智能化生成,但随着AI算法和AIGC的发展,出现了更多的生成方式。一种是基于AIGC的图像生成和视频生成,它能够达到次时代游戏人物的精度,这种生成方式可用Meta Human Creator 或 HeyGen,用户可以自定义生成数字人。另一种就是参数化模型的数字人生成,这种生产方式目前还在研究当中。这里主要介绍AIGC相关的图像和视频的生成方式。见图6;分别以虚拟互动游戏《Racing Games》中的数字人与科幻电影《阿凡达:水之道》为例,来介绍电影中的数字人生成。

图6 基于AIGC的智能图像生成过程与智能视频生成过程

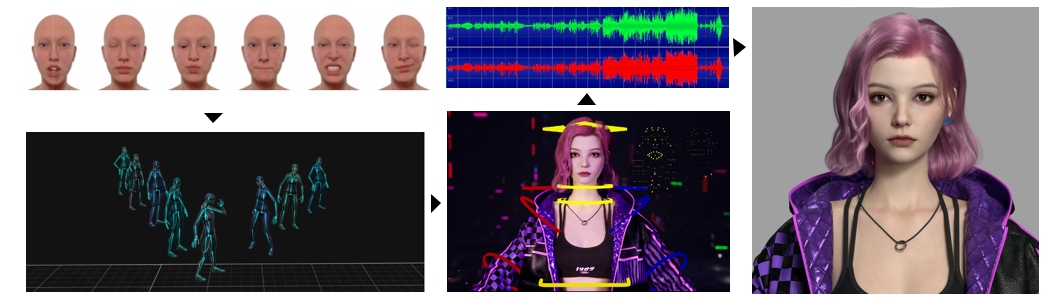

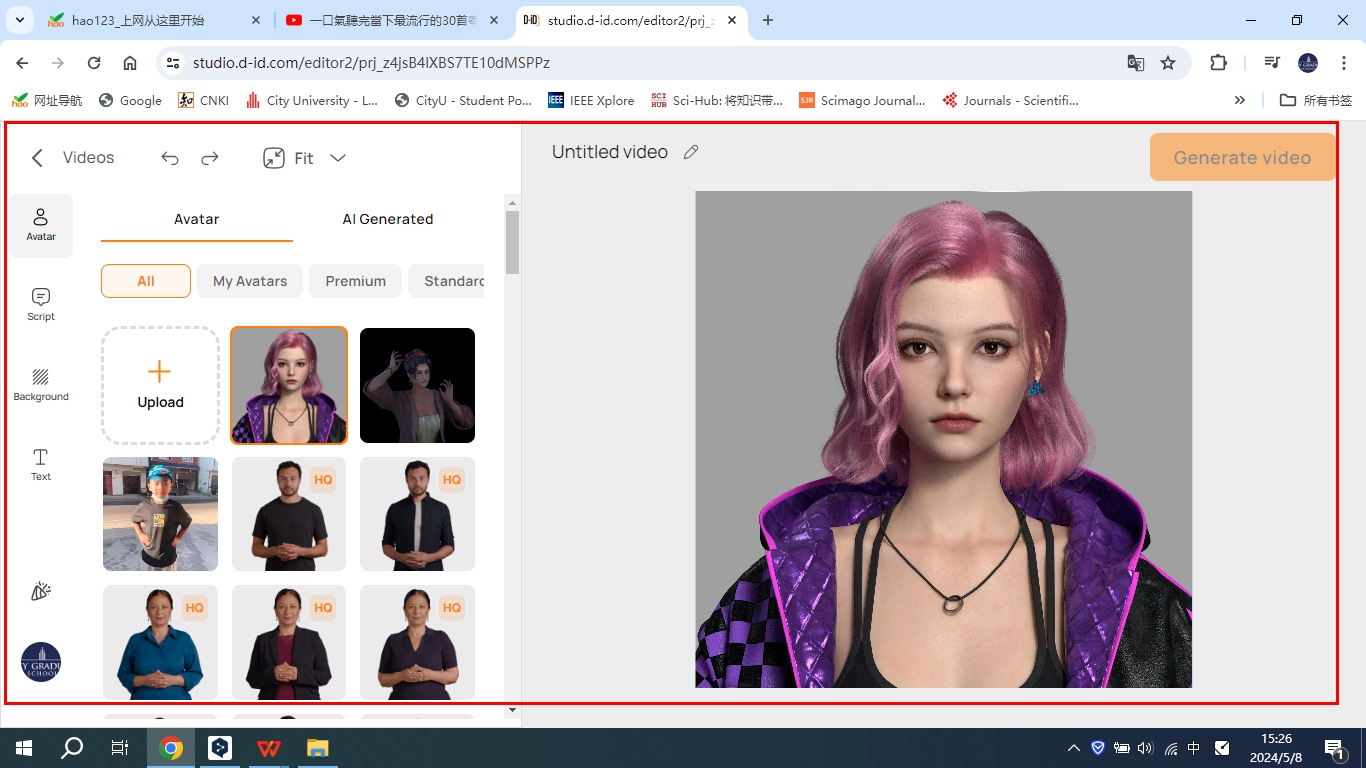

在AIGC数字人生成之前,还应当注意两个重要的智能生成方式,先来介绍图像生成,他包含材料与资产管理和图像模型视频增强。采取批量数据处理法和图像模型视频增强。在后期进行帧对帧的动画合成处理。尤其是在图像模型视频增强部分,分别使用了Animate Diff on、Hotshot-XL和Vision Crafter三大AI视频生成软件集合。处理多种镜头下的LoRA模型。方便文本转动图和支持AI智能动画生成的功能。在上两章,本文已经研究了CG角色的表情生成技术,随后可以运用AIGC生成算法的便利,基于上图中图像和视频的生成方法,来初步达到产品级的效果质量。其代表性的有Niverse Avatar和 Unreal Engine的 Meta Human Creator等平台。在这里以DI-D平台为例,载入数字人,通过输入表情、录制声音,发布文本等形式跨模态生成数字人动画。见图7。

图7 数字人表情与动画的智能生成简略图(作品来源于Racing Games 虚拟互动游戏)

介绍一下AIGC的另一种智能生成方式,那就是视频生成。在《《阿凡达:水之道》影片中,制作方大量运用了该图像生成的流程管理方式,针对大量的数字模型管理,采用视频生成模型的流程管理。当然,真人电影还是有赖于动作捕捉技术,除了制作好的CG角色微表情之外,还要采用光学式动作捕捉,利用摄像机阵列和传感器记录来跟踪表情和人体数据。除以上图表中的技术实施以外,还运用了 WetaM对真实人物的面部进行捕捉和表情映射,将之给予CG角色。在整个后期数字流程的动态管理上,添加采用Blackmagic Design提供的Teranex AV 格式转换器、Smart Videohub 12G 40X40矩阵、DeckLink 8K pro采播放卡等等设备进行集中生成。使得表情群集的图像生成更加便利和快捷。见图8。

图8 基于视频生成的数字人表情管理

图文:徐明明

太阳成集团tyc33455cc

太阳成集团tyc33455cc